Dienstag, 17. November 2015

King Of Paranoia.

Unter Paranoia versteht man die charakteristische Verbindung von Größen- und Verfolgungswahn.

Größenwahn bei sonst klarem Verstand kann die Augen nicht verschließen vor der Diskrepanz zwischen Selbstwahrnehmung und dem Urteil der Welt. Erklären kann er sie, wenn er richtig gut ist, durch allgemeine Verschwörung.

Das führt uns zum nächsten charakteristischen Merkmal der Paranoia: dem Beziehungswahn. Da er der Größte ist, kann sich der Paranoiker nicht vorstellen, dass auf der Welt etwas passiert, das ohne Bezug auf IHN wäre.

Dazu bedarf er einer großen Mühe, des weiteren Merkmals der Paranoia: des Interpretationswahns. Alles ist Zeichen, doch Zeichen wofür? Für den geheimen Bezug auf IHN, den die Verschwörer leugnen und den nur der Betroffene erkennt. Das pausenlose Interpretieren kostet viel geistige Energie. Nicht jeder kann sich eine echte Paranoia leisten, nur die Klügeren.

*

Hinzu kommt im klinischen Befund, ohne dass es eine logische oder genetische Verbindung gäbe, die typische Erotomanie des Paranoikers: Bei ihm geht nichts ohne Sex.*

Sie merken es, lieber Leser: Ich spreche vom Wahnsystem des Professors Freud.**

_____________________________________________

*) Viele Paranoiker sind außerdem Säufer. Ist das Zufall oder liegt es in der Sache selbst? Säufer war Freud wohl nicht, oder? Gestorben ist er immerhin an Kehlkopfkrebs, der mit Nikotin- und Alkoholmissbrauch in Verbindung gebracht wird.

**) Aber ich will schon noch ein gutes Haar an ihm lassen: "Wer Trinken, Rauchen und Sex aufgibt, lebt auch nicht länger. Es kommt ihm nur so vor", wird ihm zugeschrieben, und das klingt wieder nach gesundem Men-schenverstand.

Samstag, 14. November 2015

Konsonanten bevorzugen gemäßigtes Klima.

Je heißer das Land, umso mehr Vokale?

Linguisten sehen einen Zusammenhang zwischen dem Klima und dem Sound menschlicher Sprachen.

Warum klingen die Sprachen so verschieden? Warum gibt es just in slawischen Sprachen so viele gehäufte Konsonanten? Warum verzichtet das Chinesische, aber auch das Italienische weitgehend auf geschlossene Silben? Warum kommen die Klick- und Schnalzlaute fast nur in den Khoisansprachen des südlichen Afrika vor? Wieso ist im Türkischen das Ü und im Schwedischen das Ö so häufig?

Man wird wohl nie alle Charakteristika von Sprachen erklären können, weder aus kulturellen Eigenheiten noch aus naturräumlichen Faktoren. Doch schon länger grassiert eine simple, aber einleuchtende These darüber, wie das Klima die Sprachen prägen könnte: Menschen in warmen Gegenden verbringen mehr Zeit draußen, kommunizieren dort über weitere Distanzen. Sie sollten also Lautkombinationen bevorzugen, die auch unter schlechten Bedingungen gut über große Strecken übertragen werden.

Linguisten um Ian Maddieson (University of New Mexico) präsentierten nun bei der Tagung der Acoustical Society of America in Florida eine Theorie, die diese Idee verfeinert. Maddieson beruft sich dabei explizit auf eine Parallele aus der Zoologie: Singvögel verwenden eher Frequenzen, die in ihren Habitaten gut übertragen werden, so singen Waldvögel tiefer als Vögel in offenen Arealen. Denn Bäume lenken die Schallwellen ab.

Mehr Bäume, weniger Konsonanten

In menschlichen Sprachen sind Konsonanten besonders anspruchsvoll, was den Frequenzbereich anbelangt; das ist ein Grund, warum alte Leute, die die hohen Frequenzen nicht mehr hören können, Sprache so schlecht verstehen. „Das könnte erklären, warum Sprachen in Gegenden mit größerer Baumdichte dazu neigen, weniger konsonantenreich zu sein“, meint Maddieson. Aber nicht nur die Vegetation beeinflusse die bevorzugten Laute von Sprachen, sondern auch die Temperatur: Warme Luft könne kleine Wellen bilden, die die Übertragung hoher Frequenzen stören. Tatsächlich fand Maddieson eine Korrelation der Konsonantendichte von Sprachen mit der Gegend, wo sie gesprochen werden: mit Baumdichte, Niederschlag, Temperatur. Sprachen in feuchteren und heißeren Gebieten seien weniger „consonant-heavy“, fasst er zusammen.

Für ihre Analyse verwendeten die Linguisten immerhin 633 Sprachen, dabei schlossen sie aber Weltsprachen wie Spanisch, Englisch und Mandarin aus: Deren Verbreitung hat gewiss nichts mehr mit den Naturräumen zu tun, in denen sie einst entstanden sind. (tk)

Donnerstag, 12. November 2015

Prosodie und Bedeutung.

aus scinexx

Vom Tonfall zur Bedeutung

Unser Gehirn erkennt subtile Unterschiede im Tonfall über verschiedene neuronale Pfade

Der Ton macht die Musik: Forscher haben herausgefunden, wie unser Gehirn subtile Veränderungen im Tonfall eines Sprechers wahrnimmt und verarbeitet. Dabei stießen sie auf Überraschungen: Beim Interpretieren des Tonfalls spielt unser Gehirn die Kehlkopfbewegungen nach, mit denen die Töne entstanden. Außerdem liegen die dazu nötigen komplexen Netzwerke von Nervenzellen in einer anderen Hirnhälfte als diejenigen zur Erkennung von Sprache, beschreiben die Neurologen im Magazin "Current Biology".

Sprache ist mehr als nur aneinandergereihte Worte: Der Tonfall, in dem wir diese Worte aussprechen, trägt entscheidend zu deren Bedeutung bei. Oft verrät er sogar mehr über die Ansichten des Sprechers als die rein wörtliche Bedeutung des Gesagten. "Stellen Sie sich doch einfach mal ein leidenschaftlich, ein zögerlich oder ein ironisch gesprochenes 'Ja' in Antwort auf einen Heiratsantrag vor", schlägt Daniela Sammer vom Max-Planck-Instituts für Kognitions- und Neurowissenschaften in Leipzig vor. "Da haben Sie ein anschauliches Beispiel für die wichtige Funktion des Tonfalls."

Auf die Verbindungen kommt es an

Diesen Aspekt der Sprache fassen Wissenschaftler unter dem Begriff Prosodie zusammen. Diese beinhaltet alle sprachlichen Eigenschaften wie Akzent, Intonation oder auch Sprechpausen. Wie das Gehirn diesen wichtigen Teil unserer Kommunikation verarbeitet, war jedoch bislang unklar.

Zwar ist bekannt, dass die reinen Wortlaute vor allem in den Sprachzentren der linken Gehirnhälfte entschlüsselt werden. Menschliches Verhalten und auch die Sprache lassen sich aber nicht nur auf einzelne Hirnregionen reduzieren – es kommt vor allem auf die Verbindungen zwischen den einzelnen Bereichen an. Solche existierenden Pfadmodelle lieferten bislang keine Anhaltspunkte über die Verarbeitung der Prosodie.

Aktive Hirnregionen in der rechten Hirnhälfte beim Entschlüsseln der Prosodie

Die Ergebnisse zeigten zunächst zwei Gruppen aktiver Regionen in der rechten Hirnhälfte. Die erste Gruppe besteht aus dem vorderen und hinteren superioren temporalen Sulcus, der obersten der drei Furchen im Schläfenlappen des Gehirns. Diese Areale könnten Stationen sein, die den charakteristischen akustischen Verlauf der Tonhöhen bei Fragen oder Aussagen heraushören und entsprechend interpretieren, sagen die Forscher.

Gehirn stellt Bewegung des Kehlkopfes nach

Die zweite Gruppe bilden aktive Gebiete im sogenannten inferioren Frontallappen (IFG) und dem prämotorischen Kortex (PMC) in dem Areal, welches die Bewegungen des Kehlkopfes steuert. "Der IFG unterstützt die Bewertung des Tonfalls, während der PMC an dieser Stelle die Vibration der Stimmbänder und somit die Tonhöhe einer Äußerung kontrolliert", erklärt Sammler. "Dieser Befund ist sehr interessant, da die Probanden die Stimuli lediglich hörten und nicht selbst sprachen."

Die Studienteilnehmer stellten offenbar die nötigen Kehlkopfbewegungen, die der Sprecher jeweils für ein Wort benutzte, intern nach. Das Gehirn übersetzt Gehörtes also auch in einen Bewegungsbefehl. Dies fördert das Verständnis von Sprache, indem der Hörer in sich selbst das Gehirn die Bewegungsprogramme rekonstruiert, die ein Sprecher für die Produktion des Gehörten selbst genutzt hat. "Bislang vermutete man diesen Aspekt nur für die nichtprosodische Sprachverarbeitung in der linken Hemisphäre", sagt Sammler. "Die vorliegenden Daten könnten aber für einen ähnlichen Mechanismus in der Wahrnehmung des Tonfalls sprechen."

Feine Untertöne über flexible Pfade unterscheidbar

Darüber hinaus bestimmten die Forscher die Bündel von Nervenfasern der weißen Substanz, die dem Informationsaustausch in diesem Netzwerk zugrunde liegen. Dafür berechneten die Forscher die anatomischen Verbindungen zwischen den aktivierten Gehirnregionen aus den Gehirnbildern der Studienteilnehmer.

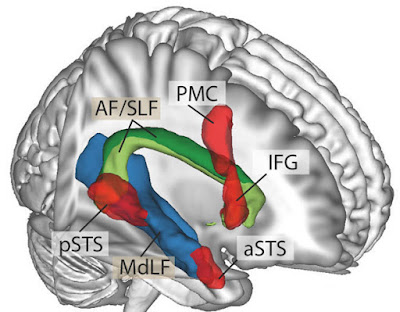

Faserbündel-Pfade in der rechten Hirnhälfte für die Prosodie-Wahrnehmung.*

Die Ergebnisse zeigen deutlich zwei Faserbündel, die die beiden zuvor erkannten aktiven Gruppen in der rechten Hirnhälfte miteinander verbinden. Eines folgt dem sogenannten mittleren longitudinalen Fasciculus, das zweite dem folgt dem Verlauf des Fasciculus arcuatus beziehungsweise des superioren longitudinalen Fasciculus. Dieser ist in der linken Hemisphäre bereits als Verbindungsbahn zwischen den Sprachzentren bekannt.

Das Gehirn nimmt den Tonfall einer Sprache also entlang mehrerer Pfade wahr. Im Unterschied zu anderen Signalpfaden für Sprache liegen sie vor allem in der rechten Hirnhälfte. "Vermutlich lassen sich diese Pfade flexibel kombinieren und erfüllen so unterschiedliche Aufgaben", fasst Sammler zusammen. "Dadurch kann das Gehirn feine Untertöne in der Stimme des Gegenübers erkennen." Die genaue Kenntnis dieses Prosodie-Netzwerkes helfe auch beim Verständnis zwischenmenschlicher Kommunikation und ihrer Störungen. (Current Biology, 2015; doi: 10.1016/j.cub.2015.10.009)

(Max-Planck-Institut für Kognitions- und Neurowissenschaften, 09.11.2015 - AKR)

*) Faserbündel-Pfade in der rechten Hirnhälfte für die Prosodie-Wahrnehmung. Posteriorer (pSTS) und anteriorer (aSTS) superiorer temporaler Sulcus, inferiorer Frontallappen (IFG) und prämotorischer Kortex (PMC) sind entlang dem Fasciculus arcuatus (AF) beziehungsweise dem superioren longitudinalen Fasciculus (SLF) miteinander vernetzt.

Nota. - Das digit, das digitale Symbol schlechthin ist das Wort, daran ändert das binäre Darstellungssystem aus I und O nichts: denn die bedeuten eben sinnhaltige Worte mit ja oder nein. Und jetz muss man sagen: das geschriebene Wort. Denn nur dieses lässt sich mit I und O auszeichnen, nicht das gesprochene: denn das muss zusätzlich auf analoge Weise entschlüsselt werden, mit dem Ohr: hörend. Da lässt sich mit I und O nichts anfangen.

Das ist unter anderm theoretisch interessant. Aber praktisch (unter anderm) auch deshalb, weil es der Hype um die bildgebenden Verfahren der Hirnforschung einen deutlichen Dämpfer verpasst. Denn was diese Verfahren beobachten, sind zwar analoge (elektrochemische) Vorgänge zwischen den Hirnzellen. Aber sie halten sie auf digitale Weise fest. Die digitalen Chiffren werden dann zwar wieder in analoge Bilder umgesetzt. Aber sie können nur das analog umsetzen, was zwischendurch digital erfasst war; was sich der digitalen Erfassung eventuell entzog, ist verloren gegangen. - Es sei denn, man nähme an, das Gehirn habe den aus den analogen Signalen (re)konstruierten Sinn selber schon digital umgerechnet und als solchen behalten; was die digitalen Messinstrumente erfassen, sei daher der unverkürzte Sinn selbst!

Praktisch ist es insofern, als damit alle Phantasien über maschinelles Gedankenlesen bereits auf technischer Ebene der Boden entzogen ist; die semantischen Probleme bei der Umsetzung von Zeichen in Bedeutung ist da noch nicht einmal berührt.

(Hab ich mich verheddert? Egal: Sie können sicher sein, dass die heutigen Akkord-Forscher sich solche Fragen nicht einmal stellen. Und die Koriphäen, die das könnten und wollten, machen Grundlagenfor-schung, für Anderes haben sie keine Zeit.)

JE

Vom Tonfall zur Bedeutung

Unser Gehirn erkennt subtile Unterschiede im Tonfall über verschiedene neuronale Pfade

Der Ton macht die Musik: Forscher haben herausgefunden, wie unser Gehirn subtile Veränderungen im Tonfall eines Sprechers wahrnimmt und verarbeitet. Dabei stießen sie auf Überraschungen: Beim Interpretieren des Tonfalls spielt unser Gehirn die Kehlkopfbewegungen nach, mit denen die Töne entstanden. Außerdem liegen die dazu nötigen komplexen Netzwerke von Nervenzellen in einer anderen Hirnhälfte als diejenigen zur Erkennung von Sprache, beschreiben die Neurologen im Magazin "Current Biology".

Sprache ist mehr als nur aneinandergereihte Worte: Der Tonfall, in dem wir diese Worte aussprechen, trägt entscheidend zu deren Bedeutung bei. Oft verrät er sogar mehr über die Ansichten des Sprechers als die rein wörtliche Bedeutung des Gesagten. "Stellen Sie sich doch einfach mal ein leidenschaftlich, ein zögerlich oder ein ironisch gesprochenes 'Ja' in Antwort auf einen Heiratsantrag vor", schlägt Daniela Sammer vom Max-Planck-Instituts für Kognitions- und Neurowissenschaften in Leipzig vor. "Da haben Sie ein anschauliches Beispiel für die wichtige Funktion des Tonfalls."

Auf die Verbindungen kommt es an

Diesen Aspekt der Sprache fassen Wissenschaftler unter dem Begriff Prosodie zusammen. Diese beinhaltet alle sprachlichen Eigenschaften wie Akzent, Intonation oder auch Sprechpausen. Wie das Gehirn diesen wichtigen Teil unserer Kommunikation verarbeitet, war jedoch bislang unklar.

Zwar ist bekannt, dass die reinen Wortlaute vor allem in den Sprachzentren der linken Gehirnhälfte entschlüsselt werden. Menschliches Verhalten und auch die Sprache lassen sich aber nicht nur auf einzelne Hirnregionen reduzieren – es kommt vor allem auf die Verbindungen zwischen den einzelnen Bereichen an. Solche existierenden Pfadmodelle lieferten bislang keine Anhaltspunkte über die Verarbeitung der Prosodie.

Aktive Hirnregionen in der rechten Hirnhälfte beim Entschlüsseln der Prosodie

Die Ergebnisse zeigten zunächst zwei Gruppen aktiver Regionen in der rechten Hirnhälfte. Die erste Gruppe besteht aus dem vorderen und hinteren superioren temporalen Sulcus, der obersten der drei Furchen im Schläfenlappen des Gehirns. Diese Areale könnten Stationen sein, die den charakteristischen akustischen Verlauf der Tonhöhen bei Fragen oder Aussagen heraushören und entsprechend interpretieren, sagen die Forscher.

Gehirn stellt Bewegung des Kehlkopfes nach

Die zweite Gruppe bilden aktive Gebiete im sogenannten inferioren Frontallappen (IFG) und dem prämotorischen Kortex (PMC) in dem Areal, welches die Bewegungen des Kehlkopfes steuert. "Der IFG unterstützt die Bewertung des Tonfalls, während der PMC an dieser Stelle die Vibration der Stimmbänder und somit die Tonhöhe einer Äußerung kontrolliert", erklärt Sammler. "Dieser Befund ist sehr interessant, da die Probanden die Stimuli lediglich hörten und nicht selbst sprachen."

Die Studienteilnehmer stellten offenbar die nötigen Kehlkopfbewegungen, die der Sprecher jeweils für ein Wort benutzte, intern nach. Das Gehirn übersetzt Gehörtes also auch in einen Bewegungsbefehl. Dies fördert das Verständnis von Sprache, indem der Hörer in sich selbst das Gehirn die Bewegungsprogramme rekonstruiert, die ein Sprecher für die Produktion des Gehörten selbst genutzt hat. "Bislang vermutete man diesen Aspekt nur für die nichtprosodische Sprachverarbeitung in der linken Hemisphäre", sagt Sammler. "Die vorliegenden Daten könnten aber für einen ähnlichen Mechanismus in der Wahrnehmung des Tonfalls sprechen."

Feine Untertöne über flexible Pfade unterscheidbar

Darüber hinaus bestimmten die Forscher die Bündel von Nervenfasern der weißen Substanz, die dem Informationsaustausch in diesem Netzwerk zugrunde liegen. Dafür berechneten die Forscher die anatomischen Verbindungen zwischen den aktivierten Gehirnregionen aus den Gehirnbildern der Studienteilnehmer.

Faserbündel-Pfade in der rechten Hirnhälfte für die Prosodie-Wahrnehmung.*

Die Ergebnisse zeigen deutlich zwei Faserbündel, die die beiden zuvor erkannten aktiven Gruppen in der rechten Hirnhälfte miteinander verbinden. Eines folgt dem sogenannten mittleren longitudinalen Fasciculus, das zweite dem folgt dem Verlauf des Fasciculus arcuatus beziehungsweise des superioren longitudinalen Fasciculus. Dieser ist in der linken Hemisphäre bereits als Verbindungsbahn zwischen den Sprachzentren bekannt.

Das Gehirn nimmt den Tonfall einer Sprache also entlang mehrerer Pfade wahr. Im Unterschied zu anderen Signalpfaden für Sprache liegen sie vor allem in der rechten Hirnhälfte. "Vermutlich lassen sich diese Pfade flexibel kombinieren und erfüllen so unterschiedliche Aufgaben", fasst Sammler zusammen. "Dadurch kann das Gehirn feine Untertöne in der Stimme des Gegenübers erkennen." Die genaue Kenntnis dieses Prosodie-Netzwerkes helfe auch beim Verständnis zwischenmenschlicher Kommunikation und ihrer Störungen. (Current Biology, 2015; doi: 10.1016/j.cub.2015.10.009)

(Max-Planck-Institut für Kognitions- und Neurowissenschaften, 09.11.2015 - AKR)

*) Faserbündel-Pfade in der rechten Hirnhälfte für die Prosodie-Wahrnehmung. Posteriorer (pSTS) und anteriorer (aSTS) superiorer temporaler Sulcus, inferiorer Frontallappen (IFG) und prämotorischer Kortex (PMC) sind entlang dem Fasciculus arcuatus (AF) beziehungsweise dem superioren longitudinalen Fasciculus (SLF) miteinander vernetzt.

Nota. - Das digit, das digitale Symbol schlechthin ist das Wort, daran ändert das binäre Darstellungssystem aus I und O nichts: denn die bedeuten eben sinnhaltige Worte mit ja oder nein. Und jetz muss man sagen: das geschriebene Wort. Denn nur dieses lässt sich mit I und O auszeichnen, nicht das gesprochene: denn das muss zusätzlich auf analoge Weise entschlüsselt werden, mit dem Ohr: hörend. Da lässt sich mit I und O nichts anfangen.

Das ist unter anderm theoretisch interessant. Aber praktisch (unter anderm) auch deshalb, weil es der Hype um die bildgebenden Verfahren der Hirnforschung einen deutlichen Dämpfer verpasst. Denn was diese Verfahren beobachten, sind zwar analoge (elektrochemische) Vorgänge zwischen den Hirnzellen. Aber sie halten sie auf digitale Weise fest. Die digitalen Chiffren werden dann zwar wieder in analoge Bilder umgesetzt. Aber sie können nur das analog umsetzen, was zwischendurch digital erfasst war; was sich der digitalen Erfassung eventuell entzog, ist verloren gegangen. - Es sei denn, man nähme an, das Gehirn habe den aus den analogen Signalen (re)konstruierten Sinn selber schon digital umgerechnet und als solchen behalten; was die digitalen Messinstrumente erfassen, sei daher der unverkürzte Sinn selbst!

Praktisch ist es insofern, als damit alle Phantasien über maschinelles Gedankenlesen bereits auf technischer Ebene der Boden entzogen ist; die semantischen Probleme bei der Umsetzung von Zeichen in Bedeutung ist da noch nicht einmal berührt.

(Hab ich mich verheddert? Egal: Sie können sicher sein, dass die heutigen Akkord-Forscher sich solche Fragen nicht einmal stellen. Und die Koriphäen, die das könnten und wollten, machen Grundlagenfor-schung, für Anderes haben sie keine Zeit.)

JE

Sonntag, 8. November 2015

Ist das Konnektom eine Schablone?

aus nzz.ch, 7. 11. 2015

Konnektomforschung

Die Entschlüsselung des Denkens

Der Hirnforscher Winfried Denk plant, ein komplettes Schaltdiagramm des Mausgehirns zu erstellen. Er hofft, damit die Rechenprinzipien des Hirns zu ergründen.

Interview von Fabienne Hübener

Herr Denk, Sie wollen das gesamte Netzwerk eines Mausgehirns entziffern. Was soll uns das bringen?

Nur so wird man in den Neurowissenschaften weiterkommen. Wir können Gehirnfunktionen nicht verstehen, wenn wir uns nur isolierte Schaltkreise anschauen, wie es im Moment geschieht. Wir brauchen das Verschaltungsdiagramm des gesamten Gehirns, das sogenannte Konnektom. Das Fehlen solcher Diagramme ist der Flaschenhals der modernen Neurowissenschaften.

Mit der von Ihnen entwickelten Zwei-Photonen-Mikroskopie können Sie Nervenzellen beim Feuern zuschauen. Das klingt spannender als Ihr derzeitiger Plan, Mausgehirne in Scheibchen mit einem Elektronenmikroskop abzubilden und nachher die Routen der Nervenzellen zu verfolgen. Warum haben Sie die Methode gewechselt?

Tatsächlich kann man mit dem Zwei-Photonen-Mikroskop dem Gehirn beim Denken zusehen. Man hört das Ploppen, wenn die Neuronen feuern, und sieht auf dem Monitor, wie die Nervenzellen aufleuchten – eine sehr befriedigende Arbeit. Aber die Frage ist doch: Warum feuert eine Nervenzelle gerade jetzt? Jede Zelle bekommt Informationen von Tausenden anderen Zellen und trifft dann eine Entscheidung: feuern oder nicht feuern. Nur wenn ich diese Verbindungen kenne, kann ich verstehen, warum eine Zelle unter bestimmten Umständen aktiv wird. So, wie ein Ingenieur beim Betrachten einer Konstruktionszeichnung bereits die arbeitende Maschine vor sich sieht, wird uns das Verknüpfungsdiagramm erlauben, Rückschlüsse auf die Funktionsweise des Schaltkreises zu ziehen. Um das Verbindungsdiagramm zu entziffern, brauche ich Bilder des Gehirns mit einer Auflösung, wie sie bis jetzt nur ein Elektronenmikroskop erreicht.

Wie weit sind Sie mit der Entschlüsselung des Mausgehirns?

Ich schätze, die Optimierung der Geräte wird noch ein paar Jahre dauern. Steht die Technik, können wir die Rohdaten innerhalb von zwei Jahren haben. Dann fängt die eigentliche Entschlüsselung an.

Wer soll die gigantische Datenmenge analysieren?

Im Moment müssen die Daten noch von Menschen analysiert werden. Ich gehe jedoch davon aus, dass die Veröffentlichung des Datensatzes einen so starken Reiz ausübt, dass Informatiker anfangen werden, automatische Analysemethoden zu entwickeln. Im besten Fall analysiert sich der Datensatz damit quasi von alleine. Aber vielleicht bin ich da auch etwas zu naiv.

Kann man Aktivität oder Funktionen mithilfe eines statischen Bilds, eben des Konnektoms, untersuchen? Das Konnektom des Fadenwurms Caenorhabditis elegans ist zum Beispiel schon lange bekannt, doch fehlt ein komplettes Modell, wie sich der Wurm fortbewegt.

Um ausgehend von der Struktur das Verhalten eines Systems vorherzusagen, muss man die dynamischen Eigenschaften der einzelnen Schaltelemente kennen, in diesem Fall der Zellen und ihrer Verbindungen, der Synapsen. Das könnte beim Mausgehirn sogar eher der Fall sein als beim Wurm, da sich weitaus mehr Neurowissenschafter mit dem Mausgehirn beschäftigen. Die Eigenschaften der Schaltelemente sind daher besser verstanden als bei C. elegans.

Was muss die Maus haben, deren Konnektom Sie aufdecken?

Da Labormäuse praktisch nichts für ihr Futter tun müssen, wird ihr Gehirn wenig gefordert. Vielleicht machen wir eine Art Mäuse-Olympiade, und die klügste Maus gewinnt. Letztlich wird man auch die Schaltpläne beider Geschlechter brauchen, schon, um sich die Unterschiede genau anzuschauen.

Welche Kritik macht Ihnen am meisten zu schaffen?

Die Kritik, es sei technisch unmöglich, spornt mich nur an. Die Kritik, wir hätten nicht genug Speicherplatz für unsere Daten, wird mit jedem Monat hinfälliger. Eine Kritik, die ich ernst nehme, aber kaum höre: Würde man wirklich verstehen, wie die Gene die Entwicklung der neuronalen Verschaltungen kontrollieren, wäre die Suche nach dem Konnektom und damit meine Arbeit überflüssig. Die Prinzipien des Denkens sind vererbt und werden nicht von jeder Generation neu erfunden.

Aber ein Grossteil der Verschaltungen entsteht durch Erfahrung. Kennen wir die beteiligten Gene, kennen wir doch immer nur einen Teil der Verschaltungen.

Sicher, zum Denken gehört auch das Gedächtnis. Aus Sicht des Neurobiologen ist jedoch vor allem das Prinzip der Gedächtnisspeicherung interessant, weniger das, an was sich eine bestimmte Maus genau erinnert. Die Prinzipien dieser Speicherung sind einfacher zu beschreiben als die Gedächtnisinhalte. Ich denke dabei an Gleichungen in der Mathematik und Physik, die mit wenigen Zeichen komplexe Phänomene beschreiben. Ganz so einfach wird es nicht sein, die Prinzipien des Denkens zusammenzufassen. Aber die Beschreibung wird viel weniger Bits benötigen als der Schaltplan eines bestimmten Gehirns.

Die Vorstellung ist ernüchternd, unser Gehirn liesse sich auf ein paar simple Prinzipien zurückführen.

Die Natur zu verstehen, bedeutet auch, sie zu entmystifizieren. Das macht sie jedoch nicht weniger grossartig. Es ist das Schöne an der Physik, dass sich mit ihr komplexe Phänomene auf einfachste Regeln zurückführen lassen. Das wird beim Gehirn nicht anders sein. Manche befürchten, die Entschlüsselung des Denkens könne dem Menschen seine Würde nehmen. Diese Sorge teile ich nicht.

Gibt es bereits Daten aus der Konnektomforschung, die etwas über Gehirnfunktionen aussagen?

Durchaus! Nehmen wir eine Zelle in der Netzhaut, die richtungsselektive Ganglienzelle. Bewegt sich das Bild auf der Netzhaut in die eine Richtung, feuert die Zelle. Bewegt es sich in die andere Richtung, wird die Aktivität unterdrückt. Erfolgt die Bewegung in einem rechten Winkel dazu, passiert nichts. Wie entsteht diese Reaktion, die so entscheidend zu unserem Sehen beiträgt? Entschlüsselt die Zelle selber die Richtung, oder erledigen das schon andere Zellen vor ihr? Das klingt nach einer einfachen Frage, war aber jahrzehntelang ein ungelöstes Rätsel der Hirnforschung. Mithilfe der Konnektomforschung haben wir herausgefunden, dass die Ganglienzelle nur Verknüpfungen mit bestimmten vorgeschalteten Zellen «zulässt» und dadurch richtungsselektiv wird. Es wäre kaum möglich gewesen, das mit einer anderen Methode herauszufinden. Allerdings gibt es bis heute weniger Erfolgsmeldungen, als mir lieb ist. Das liegt daran, dass wir nur kleine Stückchen des Konnektoms kennen. Daher will ich den ganzen Schaltplan eines Mausgehirns vor mir haben. Dann können wir die Logik hinter den Verschaltungen verstehen, davon bin ich überzeugt.

Wie repräsentativ ist das Konnektom eines einzelnen Mausgehirns?

Das wissen wir noch nicht. Aber wir wissen, dass Gehirne verschiedener Mäuse ähnliche Fähigkeiten besitzen, zumindest, wenn diese nahe verwandt sind. Das beruht vermutlich auf der Ähnlichkeit der zugrundeliegenden Rechenprozesse im Gehirn. Die Variabilität des Konnektoms von Maus zu Maus ist zwar interessant, aber für das Entdecken der Rechenprinzipien wahrscheinlich nicht so wichtig. Der Schlüssel zum wissenschaftlichen Fortschritt liegt oft darin, manche Informationen – zumindest zeitweise – wegzulassen.

Könnte man das Verschaltungsdiagramm nutzen, um es über Aktivitätsmuster, die man in anderen Studien gewonnen hat, zu legen?

Das könnte bis zu einem gewissen Grad möglich sein. Der Schaltplan wird schon während seiner Entstehung frei zugänglich sein. Jeder Wissenschafter kann dann selbst entscheiden, wie er die Informationen verwendet. Ziel ist jedoch, die mit den verschiedenen Methoden gewonnenen Einsichten miteinander zu vergleichen und nicht einfach die Daten zu überlagern.

Sie zerbrechen sich das Gehirn über das Mauskonnektom. Die Verantwortlichen des mit einer Milliarde Euro dotierten Human Brain Project wollen gleich ein ganzes menschliches Gehirn simulieren. Ist das machbar?

Wie will man etwas simulieren, dessen Struktur man nicht kennt? In meinen Augen ist das Projekt eine Fehlallokation von Forschungsgeldern. Ich bin mir zudem nicht sicher, ob die Neurowissenschaften schon reif für ein echtes Grossprojekt sind. Dafür sollte man schon genauer wissen, was am Ende herauskommt. Das war etwa beim Human-Genom-Projekt oder beim Teilchenbeschleuniger Cern der Fall. Die wahren Erfolge der Neurowissenschaft kommen bis anhin noch aus kleinen Forschergruppen, die von Neugier und Risikofreude getrieben sind. Wir müssen noch scheitern dürfen.

Immerhin veröffentlichte das Human-Brain-Projekt-Team um Henry Markram kürzlich erstmals Ergebnisse, die belegen, dass sich ein Stück Rattengehirn tatsächlich im Computer simulieren lässt.

Ich begrüsse natürlich die Veröffentlichung, aber die Ergebnisse ändern nichts an meiner grundsätzlichen Meinung zum Human Brain Project.

Ein Science-Fiction-Autor braucht Ideen für einen Roman. Was fällt Ihnen ein?

Stellen Sie sich vor, man könnte in 100 Jahren mithilfe von Konnektomdaten ein gestorbenes Gehirn wiederaufleben lassen. Das wirft romanfüllende moralische und philosophische Fragen auf.

Winfried Denk ist Biophysiker und Hirnforscher. Seit 2011 ist er Direktor des Max-Planck-Instituts für Neurobiologie in Martinsried, Deutschland.

Nota. - Ich habs mehrmals durchgesehen: Die Frage, wie aufschlussreich ein Mäusehirn für das Denken sein möchte, hat sie tatsächlich nicht gestellt. Er meint aber gar nicht denken; er meint verschalten: "Sicher, zum Denken gehört auch das Gedächtnis. Aus Sicht des Neurobiologen ist jedoch vor allem das Prinzip der Gedächtnisspeicherung interessant, weniger das, an was sich eine bestimmte Maus genau erinnert."

Sicher, zum Denken gehört auch das, was gedacht wird. Den Konnektomforscher interessiert aber eher, wie es gespeichert wird. Und zu dem Behuf setzt er einfach mal voraus, dass das, was gespeichert ist, gleich-gültig ist dafür, wie es gespeichert wird. Als heuristische Arbeitserleichterung mag das zweckmäßig sein, wenn sich's der Laie auch schlecht vorstellen kann.

Doch "andersrum wird ein Schuh draus": Worauf es beim Denken ankommt, ist ja nicht, dass man die Sinngehalte ablegen, sondern... dass man sie wiederfinden kann, nämlich wenn man sie zu etwas brauchen will. Das Wozu-man-sie-braucht bedingt offenkundig, wie man sie sucht. Und wie man sie sucht, bedingt, ob und wie man sie findet. Wenn man das Speichern vielleicht als einen rein formal beschreibbaren Schalt-kreis auffassen kann, dann doch aber ganz sicher nicht das Wiederfinden.

Hat eine Maus Zwecke, um deretwillen sie nach Erinnerungen sucht? Denkt die Maus? Mir schwirrt der Kopf. Ob seine Mauseforschung womöglich auch eine Fehlallokation von Mitteln ist?

JE

Konnektomforschung

Die Entschlüsselung des Denkens

Der Hirnforscher Winfried Denk plant, ein komplettes Schaltdiagramm des Mausgehirns zu erstellen. Er hofft, damit die Rechenprinzipien des Hirns zu ergründen.

Interview von Fabienne Hübener

Herr Denk, Sie wollen das gesamte Netzwerk eines Mausgehirns entziffern. Was soll uns das bringen?

Nur so wird man in den Neurowissenschaften weiterkommen. Wir können Gehirnfunktionen nicht verstehen, wenn wir uns nur isolierte Schaltkreise anschauen, wie es im Moment geschieht. Wir brauchen das Verschaltungsdiagramm des gesamten Gehirns, das sogenannte Konnektom. Das Fehlen solcher Diagramme ist der Flaschenhals der modernen Neurowissenschaften.

Mit der von Ihnen entwickelten Zwei-Photonen-Mikroskopie können Sie Nervenzellen beim Feuern zuschauen. Das klingt spannender als Ihr derzeitiger Plan, Mausgehirne in Scheibchen mit einem Elektronenmikroskop abzubilden und nachher die Routen der Nervenzellen zu verfolgen. Warum haben Sie die Methode gewechselt?

Tatsächlich kann man mit dem Zwei-Photonen-Mikroskop dem Gehirn beim Denken zusehen. Man hört das Ploppen, wenn die Neuronen feuern, und sieht auf dem Monitor, wie die Nervenzellen aufleuchten – eine sehr befriedigende Arbeit. Aber die Frage ist doch: Warum feuert eine Nervenzelle gerade jetzt? Jede Zelle bekommt Informationen von Tausenden anderen Zellen und trifft dann eine Entscheidung: feuern oder nicht feuern. Nur wenn ich diese Verbindungen kenne, kann ich verstehen, warum eine Zelle unter bestimmten Umständen aktiv wird. So, wie ein Ingenieur beim Betrachten einer Konstruktionszeichnung bereits die arbeitende Maschine vor sich sieht, wird uns das Verknüpfungsdiagramm erlauben, Rückschlüsse auf die Funktionsweise des Schaltkreises zu ziehen. Um das Verbindungsdiagramm zu entziffern, brauche ich Bilder des Gehirns mit einer Auflösung, wie sie bis jetzt nur ein Elektronenmikroskop erreicht.

Wie weit sind Sie mit der Entschlüsselung des Mausgehirns?

Ich schätze, die Optimierung der Geräte wird noch ein paar Jahre dauern. Steht die Technik, können wir die Rohdaten innerhalb von zwei Jahren haben. Dann fängt die eigentliche Entschlüsselung an.

Wer soll die gigantische Datenmenge analysieren?

Im Moment müssen die Daten noch von Menschen analysiert werden. Ich gehe jedoch davon aus, dass die Veröffentlichung des Datensatzes einen so starken Reiz ausübt, dass Informatiker anfangen werden, automatische Analysemethoden zu entwickeln. Im besten Fall analysiert sich der Datensatz damit quasi von alleine. Aber vielleicht bin ich da auch etwas zu naiv.

Kann man Aktivität oder Funktionen mithilfe eines statischen Bilds, eben des Konnektoms, untersuchen? Das Konnektom des Fadenwurms Caenorhabditis elegans ist zum Beispiel schon lange bekannt, doch fehlt ein komplettes Modell, wie sich der Wurm fortbewegt.

Um ausgehend von der Struktur das Verhalten eines Systems vorherzusagen, muss man die dynamischen Eigenschaften der einzelnen Schaltelemente kennen, in diesem Fall der Zellen und ihrer Verbindungen, der Synapsen. Das könnte beim Mausgehirn sogar eher der Fall sein als beim Wurm, da sich weitaus mehr Neurowissenschafter mit dem Mausgehirn beschäftigen. Die Eigenschaften der Schaltelemente sind daher besser verstanden als bei C. elegans.

Was muss die Maus haben, deren Konnektom Sie aufdecken?

Da Labormäuse praktisch nichts für ihr Futter tun müssen, wird ihr Gehirn wenig gefordert. Vielleicht machen wir eine Art Mäuse-Olympiade, und die klügste Maus gewinnt. Letztlich wird man auch die Schaltpläne beider Geschlechter brauchen, schon, um sich die Unterschiede genau anzuschauen.

Welche Kritik macht Ihnen am meisten zu schaffen?

Die Kritik, es sei technisch unmöglich, spornt mich nur an. Die Kritik, wir hätten nicht genug Speicherplatz für unsere Daten, wird mit jedem Monat hinfälliger. Eine Kritik, die ich ernst nehme, aber kaum höre: Würde man wirklich verstehen, wie die Gene die Entwicklung der neuronalen Verschaltungen kontrollieren, wäre die Suche nach dem Konnektom und damit meine Arbeit überflüssig. Die Prinzipien des Denkens sind vererbt und werden nicht von jeder Generation neu erfunden.

Aber ein Grossteil der Verschaltungen entsteht durch Erfahrung. Kennen wir die beteiligten Gene, kennen wir doch immer nur einen Teil der Verschaltungen.

Sicher, zum Denken gehört auch das Gedächtnis. Aus Sicht des Neurobiologen ist jedoch vor allem das Prinzip der Gedächtnisspeicherung interessant, weniger das, an was sich eine bestimmte Maus genau erinnert. Die Prinzipien dieser Speicherung sind einfacher zu beschreiben als die Gedächtnisinhalte. Ich denke dabei an Gleichungen in der Mathematik und Physik, die mit wenigen Zeichen komplexe Phänomene beschreiben. Ganz so einfach wird es nicht sein, die Prinzipien des Denkens zusammenzufassen. Aber die Beschreibung wird viel weniger Bits benötigen als der Schaltplan eines bestimmten Gehirns.

Die Vorstellung ist ernüchternd, unser Gehirn liesse sich auf ein paar simple Prinzipien zurückführen.

Die Natur zu verstehen, bedeutet auch, sie zu entmystifizieren. Das macht sie jedoch nicht weniger grossartig. Es ist das Schöne an der Physik, dass sich mit ihr komplexe Phänomene auf einfachste Regeln zurückführen lassen. Das wird beim Gehirn nicht anders sein. Manche befürchten, die Entschlüsselung des Denkens könne dem Menschen seine Würde nehmen. Diese Sorge teile ich nicht.

Gibt es bereits Daten aus der Konnektomforschung, die etwas über Gehirnfunktionen aussagen?

Durchaus! Nehmen wir eine Zelle in der Netzhaut, die richtungsselektive Ganglienzelle. Bewegt sich das Bild auf der Netzhaut in die eine Richtung, feuert die Zelle. Bewegt es sich in die andere Richtung, wird die Aktivität unterdrückt. Erfolgt die Bewegung in einem rechten Winkel dazu, passiert nichts. Wie entsteht diese Reaktion, die so entscheidend zu unserem Sehen beiträgt? Entschlüsselt die Zelle selber die Richtung, oder erledigen das schon andere Zellen vor ihr? Das klingt nach einer einfachen Frage, war aber jahrzehntelang ein ungelöstes Rätsel der Hirnforschung. Mithilfe der Konnektomforschung haben wir herausgefunden, dass die Ganglienzelle nur Verknüpfungen mit bestimmten vorgeschalteten Zellen «zulässt» und dadurch richtungsselektiv wird. Es wäre kaum möglich gewesen, das mit einer anderen Methode herauszufinden. Allerdings gibt es bis heute weniger Erfolgsmeldungen, als mir lieb ist. Das liegt daran, dass wir nur kleine Stückchen des Konnektoms kennen. Daher will ich den ganzen Schaltplan eines Mausgehirns vor mir haben. Dann können wir die Logik hinter den Verschaltungen verstehen, davon bin ich überzeugt.

Wie repräsentativ ist das Konnektom eines einzelnen Mausgehirns?

Das wissen wir noch nicht. Aber wir wissen, dass Gehirne verschiedener Mäuse ähnliche Fähigkeiten besitzen, zumindest, wenn diese nahe verwandt sind. Das beruht vermutlich auf der Ähnlichkeit der zugrundeliegenden Rechenprozesse im Gehirn. Die Variabilität des Konnektoms von Maus zu Maus ist zwar interessant, aber für das Entdecken der Rechenprinzipien wahrscheinlich nicht so wichtig. Der Schlüssel zum wissenschaftlichen Fortschritt liegt oft darin, manche Informationen – zumindest zeitweise – wegzulassen.

Könnte man das Verschaltungsdiagramm nutzen, um es über Aktivitätsmuster, die man in anderen Studien gewonnen hat, zu legen?

Das könnte bis zu einem gewissen Grad möglich sein. Der Schaltplan wird schon während seiner Entstehung frei zugänglich sein. Jeder Wissenschafter kann dann selbst entscheiden, wie er die Informationen verwendet. Ziel ist jedoch, die mit den verschiedenen Methoden gewonnenen Einsichten miteinander zu vergleichen und nicht einfach die Daten zu überlagern.

Sie zerbrechen sich das Gehirn über das Mauskonnektom. Die Verantwortlichen des mit einer Milliarde Euro dotierten Human Brain Project wollen gleich ein ganzes menschliches Gehirn simulieren. Ist das machbar?

Wie will man etwas simulieren, dessen Struktur man nicht kennt? In meinen Augen ist das Projekt eine Fehlallokation von Forschungsgeldern. Ich bin mir zudem nicht sicher, ob die Neurowissenschaften schon reif für ein echtes Grossprojekt sind. Dafür sollte man schon genauer wissen, was am Ende herauskommt. Das war etwa beim Human-Genom-Projekt oder beim Teilchenbeschleuniger Cern der Fall. Die wahren Erfolge der Neurowissenschaft kommen bis anhin noch aus kleinen Forschergruppen, die von Neugier und Risikofreude getrieben sind. Wir müssen noch scheitern dürfen.

Immerhin veröffentlichte das Human-Brain-Projekt-Team um Henry Markram kürzlich erstmals Ergebnisse, die belegen, dass sich ein Stück Rattengehirn tatsächlich im Computer simulieren lässt.

Ich begrüsse natürlich die Veröffentlichung, aber die Ergebnisse ändern nichts an meiner grundsätzlichen Meinung zum Human Brain Project.

Ein Science-Fiction-Autor braucht Ideen für einen Roman. Was fällt Ihnen ein?

Stellen Sie sich vor, man könnte in 100 Jahren mithilfe von Konnektomdaten ein gestorbenes Gehirn wiederaufleben lassen. Das wirft romanfüllende moralische und philosophische Fragen auf.

Winfried Denk ist Biophysiker und Hirnforscher. Seit 2011 ist er Direktor des Max-Planck-Instituts für Neurobiologie in Martinsried, Deutschland.

Nota. - Ich habs mehrmals durchgesehen: Die Frage, wie aufschlussreich ein Mäusehirn für das Denken sein möchte, hat sie tatsächlich nicht gestellt. Er meint aber gar nicht denken; er meint verschalten: "Sicher, zum Denken gehört auch das Gedächtnis. Aus Sicht des Neurobiologen ist jedoch vor allem das Prinzip der Gedächtnisspeicherung interessant, weniger das, an was sich eine bestimmte Maus genau erinnert."

Sicher, zum Denken gehört auch das, was gedacht wird. Den Konnektomforscher interessiert aber eher, wie es gespeichert wird. Und zu dem Behuf setzt er einfach mal voraus, dass das, was gespeichert ist, gleich-gültig ist dafür, wie es gespeichert wird. Als heuristische Arbeitserleichterung mag das zweckmäßig sein, wenn sich's der Laie auch schlecht vorstellen kann.

Doch "andersrum wird ein Schuh draus": Worauf es beim Denken ankommt, ist ja nicht, dass man die Sinngehalte ablegen, sondern... dass man sie wiederfinden kann, nämlich wenn man sie zu etwas brauchen will. Das Wozu-man-sie-braucht bedingt offenkundig, wie man sie sucht. Und wie man sie sucht, bedingt, ob und wie man sie findet. Wenn man das Speichern vielleicht als einen rein formal beschreibbaren Schalt-kreis auffassen kann, dann doch aber ganz sicher nicht das Wiederfinden.

Hat eine Maus Zwecke, um deretwillen sie nach Erinnerungen sucht? Denkt die Maus? Mir schwirrt der Kopf. Ob seine Mauseforschung womöglich auch eine Fehlallokation von Mitteln ist?

JE

Mittwoch, 4. November 2015

Kulturgeschichte der Zeit.

Von der Sekunde bis zur Endzeit

SACHBUCH: Der Historiker Alexander Demandt hat eine monumentale Kulturgeschichte der Zeit geschrieben.

von Ludger Lütkehaus

Kaum ein Buch über "Die Zeit" oder, ohne den allzu bestimmten Artikel, über "Zeit", kommt ohne ein berühmt gewordenes Zitat des "Kirchenvaters" Augustinus aus. Es steht im elften Buch seiner "Bekenntnisse" und lautet in der Übersetzung Joseph Bernharts: "Was ist also 'Zeit'? Wenn mich niemand danach fragt, weiß ich es; will ich einem Fragenden es erklären, weiß ich es nicht."

Eine irritierende Auskunft, die die Frage nach dem Wesen der Zeit nicht beantwortet, sondern noch schwieriger macht. Der Berliner Alt-Historiker und Kulturwissenschaftler Alexander Demandt, dessen kapitales Werk "Zeit – Eine Kulturgeschichte" parallel zu dem Zeit-Buch von Rüdiger Safranski erschienen ist, indessen eigene, durchweg historische, nicht philosophische Wege geht, übersetzt: "‚Was ist Zeit?’ Dabei wusste er (Augustinus) es, konnte es aber nicht sagen."

Das freilich ist eine allzu freie Version. Sie reduziert das Problem Zeit auf das prekäre Verhältnis von Wissen und Nicht-sagen-Können, Erkenntnis und sprachlicher Artikulation, während der für Augustinus wesentliche Bezug auf die kommunikative Situation fehlt. Das ist eine Art von Antwort, gewiss, aber eine, die den Leser ratlos lässt. Er hat nichts von ihr, weil Augustinus sein Wissen an die Einsamkeit des Denkers bindet. "Was Du weißt", sagt Johann Wolfgang von Goethe im Anschluss an Augustinus, "das weißt Du nur allein".

Demandt bekennt sich denn auch als Skeptiker. Er zeigt beispielsweise, wieviel an impliziten Zeitbegriffen die expliziten schon voraussetzen, Wörter "wie Veränderung und Bewegung, wie Ereignis und Impuls, wie Vorher und Nachher, wie Folge und (...) Dauer, Vergänglichkeit und ewiger Wandel". "Zeit wird mit Hilfe von Begriffen definiert, die ihrerseits mit Hilfe des Zeitbegriffs definiert werden, so dass die Definitionen von ‚Zeit’ zirkulär werden." Allenfalls werden indirekte Annäherungsweisen, Gleichnisse, Metaphern und übertragene Begriffe der Zeit gerecht. Sie ist ein überaus schwieriges Thema. Und wer sich damit adäquat auseinandersetzen will, den wird das auf jeden Fall eines kosten: Zeit, viel Zeit. Die Maxime, die Ludwig Wittgenstein seinen gestressten Kollegen mitgegeben hat, ist die schwerste: "Lass Dir Zeit!"

Wie nötig das ist, hat Demandt schon bei seinen Vorarbeiten erfahren müssen. Das Erscheinen des Buches musste mehrfach verschoben werden. Mit seinen über 550 Seiten und 620 Anmerkungen verlangt es Lesern und Rezensenten eindrucksvolle Ausdauerleistungen ab. Aber es hält seinen Rhythmus bis zum Ende durch. Demandt zielt auf nichts Geringeres als die ganze "Kulturgeschichte der Zeit". Sein Werk sprengt so sehr jeden engeren Rahmen, dass man angesichts der schieren Masse der Belege das fakten- und aktensatte Buch manchmal für ein positivistisches Monstrum halten könnte. Aber es gewinnt dem riesigen Stoff eine Fülle überraschender Perspektiven ab.

In weit ausgreifenden diachronen Querschnitten, die mit der Geschichte der Sekunde, der Stunde, des Tages und der Woche, des Jahres und der Jahreszeiten, der Epochen und der Lebens- und Altersstufen, mit der heillosen Diskrepanz zwischen "Weltzeit und Lebenszeit", mit den Endzeiten der Apokalypsen alles Zeithafte unter der Sonne und hinter dem Mond umfasst, entfaltet Demandt ein wahres Kompendium der Zeit. Er verfügt dabei über einen Witz, der die Lektüre auch literarisch genussreich macht. Gerne glossiert er die Ergebnisse seiner Recherchen mit lakonischen Pointen. Sein astrophysikalisches Schlusswort zur Natur- und Weltgeschichte lautet: "Vom Urknall zum Wärmetod. Die Geschichte der Welt beginnt mit einer Katastrophe und endet in einer Sackgasse."

An die Adresse der Nostalgiker heißt es: "Früher war es auch nicht mehr wie früher." Und der Kommentar Demandts zu Herakit: "Alles fließt, natürlich bergab."

Alexander Demandt: Zeit. Eine Kulturgeschichte. Propyläen Verlag, Berlin 2015. 550 Seiten, 26 Euro.

Montag, 2. November 2015

Die Welt – wohl doch eher ein Zufall als ein intelligenter Entwurf.

aus New York Times, 17. 5. 2010

a new clue to explain existence

Physicists at the Fermi National Accelerator Laboratory are reporting that they have discovered a new clue that could help unravel one of the biggest mysteries of cosmology: why the universe is composed of matter and not its evil-twin opposite, antimatter. If confirmed, the finding portends fundamental discoveries at the new Large Hadron Collider outside Geneva, as well as a possible explanation for our own existence.

In a mathematically perfect universe, we would be less than dead; we would never have existed. According to the basic precepts of Einsteinian relativity and quantum mechanics, equal amounts of matter and antimatter should have been created in the Big Bang and then immediately annihilated each other in a blaze of lethal energy, leaving a big fat goose egg with which to make to make stars, galaxies and us. And yet we exist, and physicists (among others) would dearly like to know why.

Sifting data from collisions of protons and antiprotons at Fermilab’s Tevatron, which until last winter was the most powerful particle accelerator in the world, the team, known as the DZero collaboration, found that the fireballs produced pairs of the particles known as muons, which are sort of fat electrons, slightly more often than they produced pairs of anti-muons. So the miniature universe inside the accelerator went from being neutral to being about 1 percent more matter than antimatter.*

“This result may provide an important input for explaining the matter dominance in our universe,” Guennadi Borissov, a co-leader of the study from Lancaster University, in England, said in a talk Friday at Fermilab, in Batavia, Ill. Over the weekend, word spread quickly among physicists. Maria Spiropulu of CERN and the California Institute of Technology called the results “very impressive and inexplicable.”

The results have now been posted on the Internet and submitted to the Physical Review.

It was Andrei Sakharov, the Russian dissident and physicist, who first provided a recipe for how matter could prevail over antimatter in the early universe. Among his conditions was that there be a slight difference in the properties of particles and antiparticles known technically as CP violation. In effect, when the charges and spins of particles are reversed, they should behave slightly differently. Over the years, physicists have discovered a few examples of CP violation in rare reactions between subatomic particles that tilt slightly in favor of matter over antimatter, but “not enough to explain our existence,” in the words of Gustaaf Brooijmans of Columbia, who is a member of the DZero team.

The new effect hinges on the behavior of particularly strange particles called neutral B-mesons, which are famous for not being able to make up their minds.They oscillate back and forth trillions of times a second between their regular state and their antimatter state. As it happens, the mesons, created in the proton-antiproton collisions, seem to go from their antimatter state to their matter state more rapidly than they go the other way around, leading to an eventual preponderance of matter over antimatter of about 1 percent, when they decay to muons.

Whether this is enough to explain our existence is a question that cannot be answered until the cause of the still-mysterious behavior of the B-mesons is directly observed, said Dr. Brooijmans, who called the situation “fairly encouraging.”

The observed preponderance is about 50 times what is predicted by the Standard Model, the suite of theories that has ruled particle physics for a generation, meaning that whatever is causing the B-meson to act this way is “new physics” that physicists have been yearning for almost as long.

Dr. Brooijmans said that the most likely explanations were some new particle not predicted by the Standard Model or some new kind of interaction between particles. Luckily, he said, “this is something we should be able to poke at with the Large Hadron Collider.”

Neal Weiner of New York University said, “If this holds up, the L.H.C. is going to be producing some fantastic results.”

Nevertheless, physicists will be holding their breath until the results are confirmed by other experiments.

Joe Lykken, a theorist at Fermilab, said, “So I would not say that this announcement is the equivalent of seeing the face of God, but it might turn out to be the toe of God.”

*) Kommentar: Grad mal ein Prozent? Das riecht ja nun doch eher nach einem Zufall als nach einem durchdach-ten Plan. Oder sagen wir es so: Wenn es ein intelligenter Entwurf war, war es jedenfalls kein sehr intelligenter Entwurf. Bei so einem Schöpfer wäre man nicht gut aufgehoben.

JE

•Mai 18, 2010

•Mai 18, 2010

Sonntag, 1. November 2015

Gott würfelt.

Die Geschichte der Naturwissenschaft datiert von dem Tag, als Galileo zu der Einsicht kam, das "Buch der Natur" sei in mathematischen Zeichen geschrieben. Anstelle der platonischen Ideen wurden nunmehr die Naturgesetze den Dingen als ihr Wesen "zu Grunde" gelegt – gefasst in mathematische Formeln. Es war eine nahe liegende Konsequenz, wenn Leibniz vermutete, 'dass Gott in mathematischen Formeln denkt'. Aber keine notwendige, denn man konnte ja am Ende auch annehmen, Gott sei überflüssig, wenn man an seiner Stelle die Mathematik zur (geistigen) Substanz der (materiellen) Erscheinungen machte.

Und so konnte Albert Einstein 1926 in einem Brief an den Quantenphysiker Max Born schreiben: "Die Theorie liefert viel, aber dem Geheimnis des Alten bringt sie uns doch nicht näher. Jedenfalls bin ich überzeugt davon, dass der nicht wür-felt." Er hat bis an sein Lebensende keinen Frieden mit der Quantenphysik und ihren Unschärfen machen kön-nen, und der Satz Gott würfelt nicht ist bis heute Schlusspunkt so mancher grundlagenphysikalischen Diskussion geblieben.

Nein, nicht bis heute – nur bis vorgestern.

Am gestrigen Montag berichtet die New York Times über einen sensationellen Fund am Fermi National Accelerator Laboratory, der endlich das größte Mysterium der Kosmologie erhellen könnte: "Warum ist das Universum aus Materie zusammengesetzt und nicht aus ihrem bösen Zwilling, der Antimaterie?"

Denn "in einem mathematisch perfekten Universum wären wir noch weniger als tot; wir hätten überhaupt nie existiert". Nach Einsteins Relativität ebenso wie nach der Quantenmechanik müssten aus dem Urknall je gleich große Mengen von Materie und Antimaterie* hervorgegangen sein, die einander unmittelbar darauf in einer Flamme tödlicher Energie vernichtet hätten, und übriggeblieben wäre ein ausgeblasenes Ei.

Und trotzdem gibt es uns.

Das Fermi Laboratorium betreibt den Tevatron, bis unlängst der weltgrößte Teilchenbeschleuniger. Seine jüngsten Versuche zeigen, wie aus Feuerbällen ein ganz klein wenig mehr Teilchenpaare von sogenannten Myonen (eine Art fette Elektronen) hervorgehen, als Paare von Anti-Myonen. So bestanden die Mikrouniversen im Beschleuniger aus zu etwa einem Prozent mehr Materie als Antimaterie.

Der neu entdeckte Effekt verdankt sich einer Sorte von besonders eigenartigen Teilchen namens neutrale B-Mesonen, die dafür berüchtigt sind, dass sie sich nicht so recht entscheiden können. Sie oszillieren pro Sekunde trillionenmal zwischen ihrem regulären und ihrem Antimaterie-Zustand. Und die Mesonen, die durch den Aufeinanderprall von Protonen und Antiprotonen im Beschleuniger entstehen, gehen nun ein ganz kleines bisschen schneller aus ihrem Antimaterie-Status in den Materiestatus über, als umgekehrt. Und so kommt es schließlich zu dem etwa einprozentigen Überschuss von Materie, wenn die Mesonen zu Myonen zerfallen.

Über das vergangene Wochenende ging die Neuigkeit um die Welt, und nun wartet die Wissenschaft auf eine Überprüfung im Genfer HDC. Der soll nun herausfinden, wie die B-Mesonen zu ihrem Verhalten kommen: beim Sich-nicht-entscheiden-können ein ganz, ganz kleines bisschen schneller in die andre Richtung kippen. Es sieht doch mehr nach einer Unschärfe aus als nach einem mathematischen Gesetz.

"Ich will nicht sagen, wir hätten das Antlitz Gottes gesehen", sagt ein Mitarbeiter des Fermi-Labors; "aber vielleicht seinen kleinen Zeh."

Es sind nicht die Gedanken Gottes, aus denen die Welt entstanden ist; es war ein Kribbeln in seinem Zeh. Na schön, räumen wir’s ein: Gewürfelt hat er nicht. Er hat sich gekratzt.

*) Matter and antimatter

Matter is made up of protons, which carry a postive electric charge, electrons with a negative charge and neutrons with no charge. Antimatter is made up of antiprotons (protons with a negative charge), positrons (an electron with a positive charge) and antineutrons

Mai 18, 2010

Abonnieren

Posts (Atom)