KI macht Gedanken hörbar

Sprache aus Hirnsignalen: Forscher haben ein System entwickelt, das die Gedanken eines Menschen in hörbare und verständliche Sprache übersetzt. Ein neuronales Netzwerk wertet dabei die sprachtypischen Hirnsignale aus und wandelt sie mittels Vocoder in akustische Signale um. In ersten Tests war dieser „Gedanken-Übersetzer“ präziser und verständlicher als bisherige Ansätze, wie die Forscher berichten. Solche Systeme könnten künftig Gelähmten oder Stummen neue Sprache verleihen.

Sprache ist für unsere Kommunikation essenziell – umso verheerender ist es, wenn Menschen ihre Sprachfähigkeit durch Verletzung oder Krankheit verlieren. Schon länger versuchen Neurowissenschaftler daher, durch das Auslesen von Hirnsignalen eine direkte Schnittstelle zu unserem Denken zu schaffen. Denn wenn wir Worte hören oder sprechen, erzeugt dies charakteristische Aktivitätsmuster im Gehirn. Tatsächlich ist es Forschern bereits gelungen, gelesene Buchstaben und sogar gesprochene Sätze allein anhand der Hirnsignale zu rekonstruieren.

Verständlichkeit ist das Problem

Doch bei der Umwandlung dieser Signale in akustische, verstehbare Sprache haperte es: „Die schlechte Qualität der rekonstruierten Sprache machte diese Methoden für Gehirn-zu-Computer-Anwendungen bisher kaum nutzbar“, erklären Hassan Akbari von der Columbia University in New York und seine Kollegen.

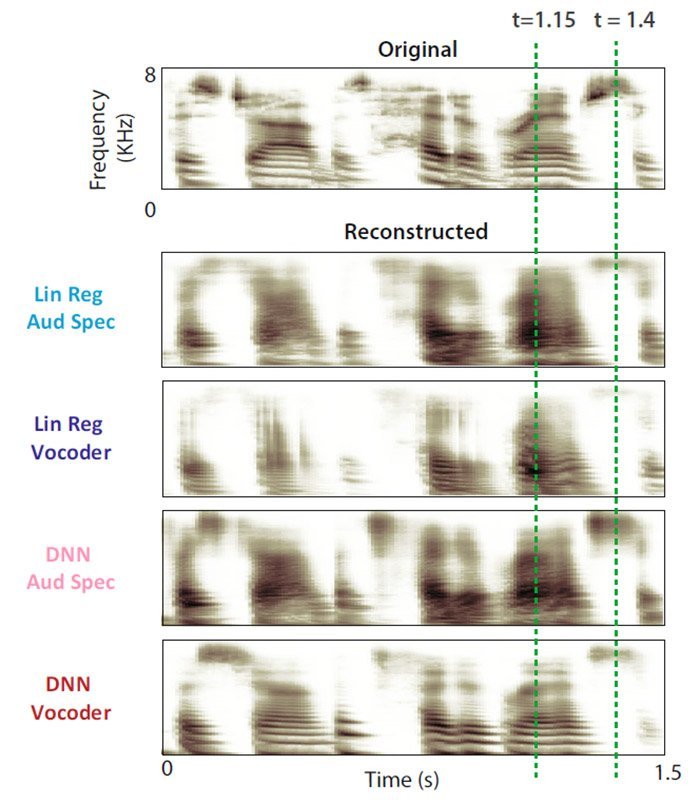

Spektrogramm

der Original-Sprachprobe und mit vier Methoden rekonstruierte

Fassungen. Die Version mit neuronalem Netz und Vocoder (DNN Vocoder)

rekonstruiert die Muster am präzisesten.

Neuronales Netz als Übersetzer

Für das Experiment nutzten Akbari und sein Team die Gehirnsignale von fünf Epilepsie-Patienten, denen in Vorbereitung einer Operation Elektroden ins Gehirn eingepflanzt worden waren. Den Probanden wurden kurze Sätze und Geschichten vorgelesen, während die Elektroden die dabei erzeugten Hirnwellen aufzeichneten. Diese Daten speisten die Forscher in ein neuronales Netzwerk ein, eine nach dem Vorbild des menschlichen Gehirns strukturierte künstliche Intelligenz.

75 Prozent richtig verstanden

Würde die so erzeugte Sprache verständlich sein? Um das zu testen, ließen die Forscher ihre künstliche Intelligenz die neuronalen Signale für die Zahlen Eins bis Neun auslesen und in akustische Sprache umwandeln – einmal durch einen Vocoder und einmal durch die herkömmlich eingesetzte Spektrogramm-Technik. Ein weiterer Test beruhte auf kurzen Sätzen. Die Soundfiles spielten die Wissenschaftler elf Freiwilligen vor. Diese sollten die richtigen Zahlen erhören und die Verständlichkeit der Sprachrekonstruktion bewerten.

Das Ergebnis: Die Kombination von neuronalem Netzwerk und Vocoder erzielte deutlich bessere Resultate als gängige Technologien. Die Probanden verstanden in 75 Prozent der Fälle die richtige Zahl. Auch die Qualität der rekonstruierten Sätze bewerteten sie höher als bei klassischen Methoden. „Der Vocoder und die leistungsstarken neuronalen Netzwerke repräsentierten die Laute, die die Patienten ursprünglich gehört hatten mit überraschender Genauigkeit“, sagt Mesgarani.

Hoffnung für sprachunfähige Menschen

Nach Ansicht der Wissenschaftler ist dies ein wichtiger Schritt, um künftig Gedanken direkt in Sprache umwandeln zu können. Denn es demonstriert, dass künstliche Intelligenz beim Auslesen der Hirnsignale entscheidende Fortschritte bringen kann. „Das zeigt, dass mit der richtigen Technologie die Gedanken von Menschen dekodiert und verstanden werden können“, so die Forscher.

Im nächsten Schritt wollen die Forscher ihre Methode nun dafür optimieren, auch neuronale Signale von nur gedachten Worten auszulesen und akustisch wiederzugeben. Denn dies könnte die Basis für künftige Neuroprothesen bilden, die gelähmten oder stummen Menschen die Sprache zurückgeben. „Das wäre ein echter Game Changer“, sagt Mesgarani. „Denn das würde jedem, der die Sprachfähigkeit verloren hat, eine neue Chance geben, mit der Welt um ihn herum zu kommunizieren.“ (Scientific Reports, 2019; doi: 10.1038/s41598-018-37359-z)

Quelle: The Zuckerman Institute at Columbia University

Keine Kommentare:

Kommentar veröffentlichen